政府のAI戦略会議座長を務める東京大学 大学院工学系研究科教授の松尾豊さんが7月20日、現在、大きな注目を集めているChatGPTに代表される生成AIの現状や可能性などについて、日本商工会議所で講演した。企業経営者にとっては非常に興味深い内容となっており、講演概要を紹介する。

松尾 豊(まつお・ゆたか)

東京大学 大学院工学系研究科教授

AI研究の長い歴史と現状

AI(人工知能)の研究は1956年からスタートしており、67年の歴史を持つ研究分野です。80年代に第2次AIブーム、2010年代から第3次AIブームが起こりました。

第3次AIブームを支える要因としては、ディープラーニング(深層学習=人間が自然に行うタスクをコンピュータに学習させる機械学習の手法の一つ)の進化、データ量の増大、GPUと呼ばれるグラフィックチップの計算能力向上があります。今、注目を集めている生成AIの位置を整理すると、まず人間と同様の知識を実現させようという取り組みやその技術であるAIという大きな枠組みがあり、その中に人がデータの特徴を定義する機械学習という領域があります。機械学習の中に機械がデータの特徴を自動定義するディープラーニング領域があり、ディープラーニングの中に生成AIがあるという包含関係になっています。

ディープラーニングは、人間の脳の神経細胞(ニューロン)を模したモデルによって学習を行う仕組みです。それぞれのユニット(=ニューロン)が、「重み和」(重みをかけた合計を求める処理)を取って、活性化関数により0-1(ゼロイチ)に丸めるという単純な処理を行うのですが、それらの集合により知的な処理を行います。

図1にある1本1本の線が重みで、重みの太さは調整ができ、太さを調整するということが学習することを意味します。線の数はパラメーターの数。ディープラーニングは12年に性能の飛躍があって、15年頃から顔認証、画像診断、自動運転など私たちの日常生活や業務で活用されています。

一方で自然言語処理と呼ばれる言葉を扱う処理は17、18年頃から着々と精度が上がってきました。精度向上の鍵となる重要な技術は二つあり、「トランスフォーマー」と「自己教師あり学習」です。話題の生成AI「ChatGPT」のような大規模言語モデルを理解するためのポイントも技術的にはこの二つだけです。

トランスフォーマーは、ディープラーニングの技術の一つですが、従来のものとだいぶ形が違い、アテンション(自己注意機構)という仕組みを使っています。アテンションは、ニューラルネットワーク(ニューロンのネットワーク構造を模した数学モデル)中のどこに注目して処理をするのかを決める機構です。人間の脳は算数をやるとき、人と話すとき、映画を見るときでは異なる回路を使います。一つのニューラルネットワークですが、入ってくる情報によって異なる回路を使うわけです。ところがトランスフォーマーは異なる回路を使うことができず、どの情報でも同じ処理をしてしまうため、アテンションを使って途中から処理のタイプ分けをしています。 「自己教師あり学習」は、Next word prediction(次の単語予測)とも呼ばれますが、自然言語処理の場合は、文章の途中までの部分を読み込ませて次の単語を予測します。これを繰り返すと次の単語がうまく当てられるモデルが出来上がります。次の単語を当てるためには、単語のつながりや文法が分かっていないといけないし、何のトピックについて書かれているのかも理解しなければなりません。次の単語を当てることで、その裏にある構造や因果関係、知識などを学習してしまうところが「自己教師あり学習」の肝なのです。これはおそらく人間の大脳皮質がやっていることと相当近い。だから高い精度が出せるのだと思っています。

トランスフォーマーと「自己教師あり学習」の二つを使うと精度が上がることが17~18年頃から分かってきて、20年には「GPT-3」が出ました。開発したOpenAI社内では、「危険すぎるから出さない方がいいのではないか」という議論がなされたほどの画期的なモデルでした。GPT-3は1750億パラメーターという大きなモデルです。パラメーターとは、図1の線の数のことで、線1本1本の“つまみ”を調整して学習していくわけです。膨大な計算が必要になるので、高い並列処理能力を持つGPUの性能が重要になります。

パラメーター数(モデルの容量)を増やせば増やすほど精度が上がる―これは「スケール則(scaling law)」と呼ばれる重要な法則です。「パラメーターの数は、データに比して適切な数にしなければならない(パラメーターの数を大きくしすぎるとオーバーフィットする)」というのが従来の常識だったのですが、この法則は常識を覆しており、中で起こっていること(なぜ性能が上がるのか)はまだ分かっていません。

いずれにしても、パラメーターの数を増やせば増やすほど性能が上がることが分かってきたので、大規模言語モデル(Large Language Models)同士の戦いが始まりました。図2のGPT-3は1750億パラメーターでしたが、中国の「悟道2・0」は1兆7500億パラメーターと桁が一つ多い。「GPT-4」はパラメーター数が公開されていませんが、推測では2200億パラメーターのものが八つあり、合計で2兆パラメーターになるといわれています。投資金額は数百億円から数千億円規模となるでしょう。

高度な対話ができるChatGPTが登場

22年11月30日に「ChatGPT」が公開されました。従来の大規模言語モデルよりも高度な意味理解と会話(チャット)が可能なことにより、ChatGPTのユーザーが各所で急速に増えています。ChatGPTの学習は次の三つのステップで構成されています。「Step 1:教師あり学習」では、このような質問をされたらこう答えるというサンプルをたくさん与えます。「Step 2:報酬モデルの学習」では、実際に人間と対話をさせて、答えが良かったら○、悪かったら×を付けます。「Step 3:強化学習」では、○がたくさんもらえるような発話をするように強化学習を行います。その結果、ChatGPTは礼儀正しい対話をしますし、膨大な数の本の内容を覚えているので、「この本の感想文を書いて」と言えば大体書くことができます。なりきり能力もとても高く、「弁当屋さんのコールセンターのオペレーターとして振る舞ってください」と言うだけで、なりきってくれます。これもすごいことで、コールセンターとは何か、弁当屋さんのオペレーターはお客さまの質問にどのように答えるべきかを教えていないにもかかわらず、「自己教師あり学習」で学習して知っているのです。「ディベートして」と言えば一人二役でディベートをしてくれます。プログラムのバグの発見や、家庭教師の代わりもします。

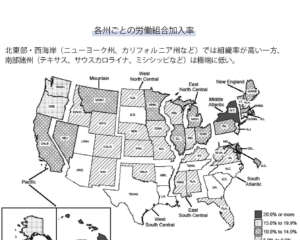

多岐にわたる利用が可能なので、ホワイトカラーの業務の相当な範囲に活用が見込めます。「目的に特化した学習」をさせれば、法律や会計、医学的な見地から正しいコメントをする専用ChatGPTをつくることもできます。 ChatGPTのような生成AIが広く使われるようになると、私たちの仕事の相当広い範囲に影響を与えそうです。OpenAIとペンシルバニア大の論文によると、米国の80%の労働者がなんらかの影響を受け、そのうち19%の労働者は50%のタスクで影響を受けるそうです。特に高賃金とか参入障壁の高い職業ほど影響が大きく、職業の例として証券金融、保険、IT(プログラマーなど)、出版業界などが挙げられています。

生成AIを巡る政府の動き

生成AIに対する日本の動きは非常に速いと思っています。ChatGPTが出てから半年ほどで国内でも話題になり、おそらく皆さまの会社の中でもどう使おうかという議論が行われていると思います。デジタルの世界でずっと仕事をしてきましたけれども、日本がここまで最先端のイノベーションに対して早く反応したことはかつてありませんでした。

私は05年から07年までスタンフォード大学の客員研究員をしていましたが、07年の8月頃に最初のiPhoneが発売されて、これはすごいと思って並んで買いました。シリコンバレーではiPhoneの話で持ちきりでしたが、日本に帰ってくると誰もiPhoneの話をしていない。日本でスマホがブームになったのは12、13年頃。5、6年遅れでした。その前のインターネットも検索エンジンもそう、ソーシャルメディアも何年か遅れて日本でブームになり、その頃には戦いが終わっているということがずっと続いてきたのですが、生成AIの場合は、世界と同じスピードで日本の中で議論がなされ、導入が検討され、いろいろなスタートアップが生まれている。それはとても素晴らしいことだと思っています。

23年2月3日に自民党により「AIの進化と実装に関するプロジェクトチーム」が立ち上がり、4月10日には岸田文雄首相がOpenAIのサム・アルトマンCEOと面会しています。G7首脳では最初の面会です。総務省、文部科学省が方針やガイドラインを次々に定め、5月11日には私が座長を務めさせていただいている「AI戦略会議」での議論が始まり、わずか15日後の26日には「AIに関する暫定的な論点整理」を公表するという速いスピードで物事が進んでいます。 「AIに関する暫定的な論点整理」では、リスクへの対応、AIの利用、AI開発力の3分野において論点整理を行いました。

①リスクへの対応は、個人情報を入れていいのか、機密情報をどうするのか、画像AIがクリエーターの作品を学習して同じような作品を作成してしまうことにどう対応していくか。

②AIの利用は、明らかに生産性を向上させ、いろいろな形で日本の社会課題を解決していく可能性があるので、人材育成・スタートアップの事業環境整備を進めるべきです。

③AI開発力は、日本は使うだけでいいのか。つくらなくていいのか。この領域は今後5年、10年で大きな産業になっていくので、日本の開発力を強化していく必要がある。開発力を強化するために必要なものは計算資源、つまりGPUです。この供給が世界中で逼迫(ひっぱく)していて、GPUの開発・製造を行う企業NVIDIA(エヌビディア)の株価がどんどん上がって時価総額100兆円に達したほどです。

GPUがどのくらい足りないのか。正確な数字は分からないのですが、私が把握している数字でいうと、日本中のGPUを1カ所に集めて、これを10倍してもなおOpenAI1社が持つGPUの数に届きません。それほどの差があるのです。この物量差の中で生成AIを開発しようとしても全く勝負にならないので、GPUを増やすために経済産業省が頑張っていますが、とにかく足元を強くすることがとても大事です。

G7でも議論が行われています。広島サミットではデジタル・技術相会合で「責任あるAI(人工知能)」の活用に向けた共同声明が採択され、日本が世界の標準ルールを取りまとめていくことが期待されています。

各企業や組織はどう動くべきか

ChatGPTの活用を表明する企業が増えています。例えばパナソニックやベネッセHD。行政では横須賀市が全国の自治体で初めてChatGPTの全庁的な活用実証を始めると発表しました。ChatGPTを活用した新たなサービスとしては、弁護士ドットコムがChatGPTを活用した法律相談チャットサービスの試験提供を始めました。ウェブサイト上で法律相談の質問を入力すると、同社が過去に蓄積してきた125万件以上の法律相談のやりとりのデータをもとにAIが自動的に相談の内容に対応した文章を表示するというものです。

香川県三豊市では、東京大学松尾研究室と連携してChatGPTを利用した「ごみ出し案内」の実証実験を行っています。ゴミの分別ルールを特に外国人が守らないと地域の人たちの不満が高まっていたのですが、そもそも外国語で分別ルールが案内されていないのだから知らないわけです。そこで「ゴミ出しChatGPT」をつくり、中国語、スペイン語、ベトナム語、韓国語、英語でも「このゴミはどう捨てる」と聞けば分別ルールに則った捨て方を答えてもらえる仕組みの運用が始まりました。

仕組みはとても簡単で、①自治体のゴミの捨て方のHPのデータを検索可能な形で保存しておく。②ユーザーの質問と関連度の高い情報を、保存データから検索し、プロンプト(ChatGPTへの指示)へ入れる。③ChatGPTがHP上のデータを参照しながら答えるというもの。つまり組織内データを検索可能にして、ChatGPTに“食わせて(覚えさせて)”、質問と合わせて答えを返せばいいのですから、どこの組織でも使えます。

ChatGPTの活用の段階には、図3のように三つのステップが考えられます。

ステップ1はChatGPTの導入です。文書執筆の支援やブレストなど一般的な活用です。

ステップ2は組織専用GPT。組織内文書を検索可能にし、プロンプトを工夫することで、問い合わせに答えられるようになります。

ステップ3は大規模言語モデル(LLM)を使った業務改革・DX。本格的に利用するための開発を行い業務フローを変える。例えば問い合わせの業務を効率化したいのであれば、ChatGPTに組織内の文書を食わせるだけでなく、それを使ってオペレーターがどう答えるのか、自動応答とオペレーターの作業分担をどう区別するのか、そのような全体のシステム設計をしなければなりません。この作業は業務改革でありDXでもあるのです。

DXがなかなか進まないと悩む経営者はChatGPT導入を契機に、ステップ1・2・3の順で進めていただきたいと思います。導入支援先としては、ChatGPTの知識を持つスタートアップがたくさんありますし、多くのベンダーが対応されていますので、ぜひ相談してください。

最後に、これから何が起こっていくのか、どこにビジネスチャンスがあるのかという話をします。

最初の問いは「バーティカル(専門分野特化)LLMと汎用LLMのどちらが市場をとるか」ということです。これは、例えば医療に特化したLLMが出てくるのか、それともGPT3が進化したGPT4、GPT5、GPT6のような汎用モデルが市場を制するのかということです。PubMedGPTという医療データを用いて学習したモデルがあります。これとGPT3を戦わせると、PubMedGPTが勝ちます。医療に特化させているわけですから当然ですね。

ところが、PubMedGPTとGPT4が戦うとGPT4が勝つ。より大きなLLMの方が勝つので、どちらの能力が高いのかはいまだに分かりません。

次に日本国内の状況です。国内企業もLLMの開発を計画・実行していて、とても素晴らしい挑戦だと思うのですが、規模は、投資額数億円、400億パラメーターという小さい開発が多く、先ほどの1750億パラメーター、2兆パラメーターに比べると桁がだいぶ小さい。小さいものをつくるのは難しくなく、松尾研究室でも100億パラメーターのものをつくっていますが、性能を上げるのが大変なことと、2兆パラメーターのものとどう戦っていくのかが課題です。日本語に特化する、医療に特化するというのであれば勝ち目がありそうですが、最初の問いで見たように汎用のものが強いのであれば勝ち目がありません。 生成AIの導入が DX推進の原動力となる 数年後を予想すると、図4のように、恐らくLLMが切り替えられるようになるでしょう。OpenAIのものを使ってもいいし、メタ、Google、日本のものを使ってもいい。これらをベースにして、各社が組織内のデータでファインチューニングをする。その上で、各社の中で使ういろいろなアプリが出てきて、それが最終的にはDXにつながる。多分このような構成になっていく。すると、セキュリティー、データ管理、プロンプト管理、ブロック化が必要になり、ここを米国のビッグテックは狙っているのでしょう。そして日本のスタートアップやITベンダーはアプリのレイヤー(各階層)からの拡大を目指している。

そうした中で、自社は、どのように生成AIの活用を進めていくのかを考える必要があると思います。ただ使うだけではあまり意味がなくて、最終的にコスト削減や付加価値の向上につなげていかないといけません。

生成AIの戦いは数兆円規模の戦いとなります。この規模の投資を日本でやろうとすると、国がいくら支援しても足りません。マイクロソフトやGoogleなどができるのは、後ろ側で数十兆円規模の売り上げがあるからです。日本が戦える体制を整えるためには、日本の巨大産業に価値を提供するような形をつくらなければなりません。巨大産業とはすなわち医療、金融、製造です。可能性はあると思っています。例えば医療分野。LLMをうまく使えば、1人の医師が診る患者の数を増やすことができます。医療事務のコストを大きく減らすこともできます。そうした仕組みを日本全体としてつくっていけるかが非常に重要で、それができるのであれば、医療、金融、製造(既にグローバル化していますが)がアジアに進出し、そこを足がかりに世界市場で成長していくことが可能になるはずです。

繰り返しになりますが、生成AIに対して日本はスピード感を持って取り組んでいます。経営者の皆さまもぜひ生成AIの導入をステップ1・2・3で進めて世界的な競争力を高め、日本の産業の発展に貢献していただければと願っております。